इस ब्लॉग श्रृंखला में, Seasalt.ai द्वारा पूर्ण आधुनिक मीटिंग अनुभव बनाने की यात्रा का अनुसरण करें, प्रारंभिक शुरुआत से लेकर विभिन्न हार्डवेयर और मॉडल पर अनुकूलन, और अंततः सबसे उन्नत NLP सिस्टम के एकीकरण तक, अंततः SeaMeet सहयोगी आधुनिक मीटिंग समाधान प्राप्त करें।

एल्गोरिथम से परे

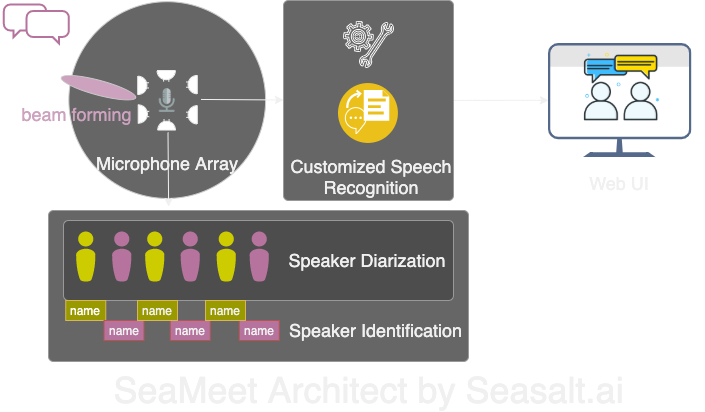

Modern Meetings एक शानदार डेमो था, लेकिन यह हमेशा डेमो स्तर पर ही रहा। इसे वास्तव में उत्पादन में लाने के लिए अभी भी लंबा रास्ता था। हमने पहले Microsoft Azure तकनीक स्टैक का उपयोग करके डेमो संस्करण को सफलतापूर्वक लागू किया। लेकिन सॉफ्टवेयर की विभिन्न कमियों को पहचानने के बाद, हमने अपने स्वयं के एल्गोरिथम से प्रतिस्थापित करने का निर्णय लिया, और पूरे अनुभव को अधिक सहज, हल्का और लचीला बनाया। Modern Meetings के चार मुख्य घटक हैं:

- माइक्रोफोन एरे का सिग्नल प्रोसेसिंग, विशेष रूप से बीमफॉर्मिंग

- स्पीकर सेपरेशन और पहचान

- कस्टम स्पीच रिकग्निशन

- बेहतर यूजर इंटरफेस

आगे हम सभी महत्वपूर्ण घटकों का विस्तार से वर्णन करेंगे।

हमने अपने तकनीक स्टैक के साथ Modern Meetings के चार मुख्य घटकों को पुनर्निर्मित किया: 1. माइक्रोफोन एरे सिग्नल प्रोसेसिंग; 2. स्पीकर सेपरेशन और पहचान; 3. कस्टम स्पीच रिकग्निशन; 4. आधुनिक वेब इंटरफेस।

माइक्रोफोन एरे का सिग्नल प्रोसेसिंग

एकल क्लोज-टॉक माइक्रोफोन की तुलना में, माइक्रोफोन एरे 360 डिग्री के दायरे से ध्वनि उठा सकता है, जो 5 मीटर तक की दूरी पर हो सकता है। इसलिए, एक माइक्रोफोन एरे 10 मीटर x 10 मीटर के मध्यम आकार के मीटिंग रूम में वॉइस एकत्र कर सकता है। सभी माइक्रोफोन एक डिवाइस पर केंद्रित होते हैं, जो मीटिंग रूम के केबल क्लटर को काफी कम कर देता है, और इंस्टॉलेशन और रखरखाव को सरल बनाता है। दूसरी ओर, माइक्रोफोन एरे का उपयोग करने का डाउनस्ट्रीम लक्ष्य हमारे मॉडल को सर्वोत्तम गुणवत्ता का डेटा प्रदान करना है। इसलिए, स्वचालित स्पीच रिकग्निशन से पहले, हम कई सिग्नल प्रोसेसिंग एल्गोरिथम लागू करते हैं। प्रीप्रोसेसिंग पाइपलाइन का मुख्य आधार बीमफॉर्मिंग एल्गोरिथम है। चूंकि हम गोलाकार मल्टी-माइक्रोफोन एरे का उपयोग कर रहे हैं, हम ध्वनि के प्रत्येक माइक्रोफोन तक पहुंचने के छोटे समय अंतर का लाभ उठा सकते हैं। बीमफॉर्मिंग का कार्य सिग्नल के मुख्य विशेषताओं (सर्वोत्तम बीम) को निर्धारित करना है, इन आवृत्तियों को बढ़ाना, साथ ही अवांछित ध्वनि को कम करना है। प्रभाव नॉइज रिडक्शन और डीरेवरबेशन है, जो मुख्य सिग्नल (वॉइस) को अधिक जोरदार और स्पष्ट बनाता है।

कई बीमफॉर्मिंग एल्गोरिथम के सर्वोत्तम प्रदर्शन के लिए स्पीकर के सापेक्ष ध्वनि स्रोत (स्पीकर) की स्थिति जानने की आवश्यकता होती है। लेकिन व्यावहारिक अनुप्रयोगों में यह लगभग असंभव है, इसलिए हम पहले ध्वनि स्रोत की दिशा निर्धारित करके फार-फील्ड वेट्स की गणना करते हैं। यह कदम साउंड सोर्स लोकेशन कहलाता है, या अधिक विशेष रूप से डायरेक्शन ऑफ अराइवल (DOA)। हमारा मुख्य मुद्दा स्मूथनेस था। एल्गोरिथम मोटे तौर पर सही परिणाम दे सकता है, लेकिन निर्धारित ध्वनि स्रोत वास्तविक दिशा के दोनों ओर 30 डिग्री के दायरे में लगातार उतार-चढ़ाव करेगा, जो बीमफॉर्मिंग को प्रभावित करता है। हमारा समाधान केवल साउंड सोर्स लोकेशन एल्गोरिथम को मानव वॉइस की मुख्य आवृत्तियों को एनकोड करने वाले फ्रीक्वेंसी बैंड का उपयोग करने देना है, और स्मूथिंग तकनीक के साथ संयोजन करना है, DOA परिणामों के “इतिहास” को औसत के लिए बनाए रखना है। अधिक विश्वसनीय DOA परिणाम हमें फार-फील्ड वेट्स की गणना करने और सर्वोत्तम बीम निर्धारित करने में सक्षम बनाते हैं।

Kinect DK पर चलने वाले एल्गोरिथम की श्रृंखला: बीमफॉर्मिंग, नॉइज रिडक्शन, डीरेवरबेशन, साउंड सोर्स लोकेशन, हमें रीयल-टाइम में स्पष्ट और बढ़ी हुई मानव वॉइस उत्पन्न करने में सक्षम बनाती है, और स्पीकर की दिशा का मोटा अनुमान लगाती है। यह अगले चरण स्पीकर पहचान में बहुत मदद करेगा।

स्पीकर सेपरेशन और पहचान

मीटिंग ट्रांसक्रिप्शन सिस्टम का अगला महत्वपूर्ण घटक स्वचालित स्पीकर पहचान है। जैसा कि इस श्रृंखला के पिछले भाग में वर्णित है, स्पीकर जानकारी के बिना अव्यवस्थित वार्तालाप टेक्स्ट पढ़ना निराशाजनक है, जो पूरी तरह से सिस्टम का अर्थ खो देता है। यहीं पर स्पीकर पहचान काम आती है।

इस घटक के माध्यम से, हम स्वचालित रूप से ट्रांसक्रिप्शन और ऑडियो को स्पीकर नामों के साथ संरेखित कर सकते हैं। यह सेपरेशन तकनीक का उपयोग करके लागू किया जाता है, जो ऑडियो सेगमेंट को रिकॉर्डिंग में स्पीकर की संख्या के बराबर समूहों में क्लस्टर करता है। यह विधि वॉइस एक्टिविटी डिटेक्शन (VAD) सिस्टम का उपयोग करके वॉइस सेगमेंट निर्धारित करती है, जहां से छोटे विंडो के वेक्टर प्रतिनिधित्व निकाले जाते हैं। प्रत्येक विंडो से निकाला गया वेक्टर यूटरेंस-लेवल xvector कहलाता है, जिसे औसत करने पर स्पीकर-लेवल xvector प्राप्त होता है। फिर इन xvector को क्लस्टर किया जाता है, प्रत्येक क्लस्टर एक ही स्पीकर से संबंधित वॉइस सेगमेंट का प्रतिनिधित्व करता है। यह ध्यान देने योग्य है कि क्लस्टरिंग एल्गोरिथम का चयन सेपरेशन प्रदर्शन को बहुत प्रभावित करता है, हमने थ्रेशोल्ड अफिनिटी मैट्रिक्स का उपयोग करके और नॉर्मलाइज्ड मैक्सिमम इगेनगैप (NME) मान के साथ स्वचालित रूप से ट्यून किए गए स्पेक्ट्रल क्लस्टरिंग एल्गोरिथम का उपयोग करके सर्वोत्तम सेपरेशन एरर रेट (DER) प्राप्त किया। अंत में, प्रत्येक क्लस्टर द्वारा प्रतिनिधित्व किए गए स्पीकर को निर्धारित करने की आवश्यकता होती है। मीटिंग से पहले 40 सेकंड की रिकॉर्डिंग से प्रत्येक स्पीकर का xvector निकाला जा सकता है, जिसे क्लस्टर परिणामों के साथ मिलान करके संबंधित स्पीकर की पहचान की जा सकती है।

इस प्रक्रिया की लचीलापन यह है: कई मीटिंग परिदृश्यों में, पहले से प्रत्येक स्पीकर की रिकॉर्डिंग प्राप्त करना व्यावहारिक नहीं है। उदाहरण के लिए, VIP ग्राहकों के साथ व्यावसायिक मीटिंग या 50 स्पीकरों के साथ बड़े सेमिनार। ऐसे मामलों में, पंजीकरण चरण को छोड़कर, हमारा सेपरेशन सिस्टम अभी भी वॉइस सेगमेंट को समूहबद्ध कर सकता है। प्रत्येक क्लस्टर से कुछ सेकंड का ऑडियो निकालकर स्पीकर की पहचान निर्धारित करने के लिए केवल मैनुअल कार्य की आवश्यकता होती है। समर्पित आधुनिक यूजर इंटरफेस के साथ, समान कार्यक्षमता लेकिन अधिक लचीलेपन के साथ प्रदान किया जा सकता है।

कस्टम स्पीच रिकग्निशन

Microsoft मीटिंग ट्रांसक्राइबर की शक्ति को समझने के बाद, हम सिस्टम को पूरी तरह से स्वतंत्र बनाने के लिए तैयार थे, मौजूदा क्रांतिकारी उत्पाद से परे। Modern Meetings और किसी भी ट्रांसक्रिप्शन उत्पाद का मुख्य आधार स्वचालित स्पीच रिकग्निशन (ASR) मॉडल है, इसलिए हमने सबसे अधिक ध्यान दिया। Azure Cognitive Services विभिन्न भाषाओं और बोलियों के मॉडल के विकल्प प्रदान करता है, लेकिन विभिन्न बोलियों के बीच प्रदर्शन को अलग करना मुश्किल है। अंग्रेजी की विभिन्न बोलियों के लिए, सबसे अधिक प्रयास और डेटा संभवतः अमेरिकी अंग्रेजी मॉडल पर केंद्रित हो सकते हैं, फिर विभिन्न बोलियों के मॉडल बनाने के लिए एक्सेंटेड डेटा के साथ फाइन-ट्यून किया जा सकता है। हम यह सुनिश्चित करना चाहते हैं कि यदि स्वतंत्र मॉडल प्रदान किए जाते हैं, तो वे विशिष्ट उपयोग के मामलों के लिए अनुकूलित हों। इसका मतलब है कि हजारों घंटे का स्थानीयकृत ऑडियो और ट्रांसक्रिप्शन एकत्र करना, और सप्ताहों का प्रशिक्षण और फाइन-ट्यूनिंग निवेश करना। लेकिन मॉडल को हर epoch में सुधार करते हुए देखना और वादे को पूरा करना बहुत संतोषजनक है।

एक मजबूत बेस मॉडल के साथ, अगला कदम उपलब्धता और कस्टमाइजेशन का विस्तार करना है। प्रत्येक उद्योग में बड़ी मात्रा में स्वामित्व शब्दावली होती है, जो ASR मॉडल को दुर्लभ शब्दों और सामान्य, समान ध्वनि वाले शब्दों के बीच अंतर करना मुश्किल बनाती है।

हमारा समाधान SeaVoice है, जो उपयोगकर्ताओं को विशिष्ट आवश्यकताओं के लिए मॉडल को फाइन-ट्यून करने के लिए एक केंद्रीकृत प्लेटफॉर्म प्रदान करता है।